Objectif du projet PLAIBDE

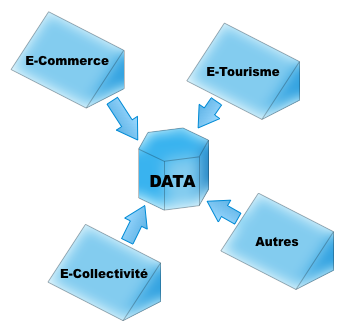

Développement d'un écosystème Big-Data métier dans les domaines d'activités relevant de l'expertise de l'entreprise aYaline : e-Commerce, e-Tourisme, e-Collectivé et d’autres.

Toutes les actions qui seront menées dans ce projet, se feront sur la base des connaissances de l'entreprise et celles de ses partenaires technologiques et scientifiques (laboratoire L3i-ULR, laboratoire LIAS-ENSMA).

Les principales actions dans ce projet

- Élaboration de la stratégie générale

- Identification des verrous scientifiques et technologiques

- Mise en place de la stratégie de recherche et développement

- Développement et industrialisation du système

Elaboration de la stratégie générale

Ce projet est une collaboration dans le domaine de la recherche, l'innovation et le transfert de technologie. Cette collaboration se fait entre trois partenaires.

L'entreprise aYaline qui a un savoir faire en développement de logiciel, son industrialisation, et la gestion de son cycle de vie. Cette maîtrise s'appuie sur une connaissance approfondie des domaines d'applications et les besoins des utilisateurs

Les deux laboratoires de recherche L3i-ULR et LIAS-ENSMA mènent des travaux de recherche en particulier dans le domaine de la science des grandes masses de données et les architectures systèmes et logicielles associées.

L'objectif de l'action « Elaboration de la stratégie générale » est de procéder à une convergence scientifique, technologique et technique entre les partenaires dans l'axe principal du projet :

« écosystème Big-Data métier ». Cette action doit être conduite au sein du projet afin de produire un ensemble de livrables terrains qui seront la base des actions de recherche et développement futurs.

Identification des verrous scientifiques et technologiques

La notion de grandes masses de données, dite aussi Big-Data, implique donc trois verrous scientifiques et technologies structurelles fondamentaux :

Changement quantitatif : explosion de l'échelle des volumes de données à traiter. La chaine de création de valeur est considérablement affectée car les données sont au coeur de la production.

Changement qualitatif : il ne s'agit plus de données structurées ou préalablement échantillonnées, mais il s'agit de données hétérogènes, éparses, structurées ou non-structurées. Ces données sont aussi temps réel, autrement dit, il faut les traiter à l'instant ou elles arrivent et non pas en différé. Aussi, avec ces données on passe d'une logique de silos, essentiellement basée sur les tables, à une logique de flux .

Variabilité : le format et le sens des données peut varier au fil du temps.

Ces verrous engendrent la problématique fondamentale : « comment traiter ces données ? ». Traditionnellement, on construisait une représentation de la réalité à travers des agrégats de données structurées comme dans les bases de données relationnelles, ou consolidées comme dans les entrepôts de données. Cette représentation de la réalité ne peut être appliquée aux grandes masses de données. On doit proposer des outils de gestion et de traitement de données qui sont le reflet du monde réel.

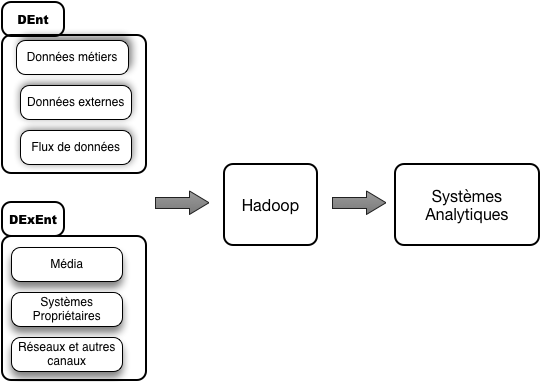

Face au gigantisme des masses de données, les systèmes de gestion des données entreprise et les architectures métiers classiques ont du mal à suivre et atteignent vite leurs limites (coûts et performances). Les entreprises qui souhaitent explorer ces masses de données se sont donc mises en quête de nouvelles solutions. Parmi celles-ci, le framework Hadoop est à l'heure actuelle, l'une des options suscitant le plus d'intérêt au sein des entreprises. Dans l'étude publiée en 2013, le cabinet d'analystes Gartner souligne ainsi que :

« les organisations sont conscientes de la force que l’analyse basée sur Hadoop peut apporter aux projets Big-Data »

en particulier quand ceux-ci concernent :

« des données faiblement structurées, du texte, de l’analyse comportementale ou qu’il s’agit de requêtes basées sur des notions de temps ».

La considération de cet écosystème dans la nouvelle architecture pour la gestion des masses de données pose plusieurs verrous scientifiques et technologiques, à savoir deux problématiques importantes :

- Comment articuler la gestion des données entreprise dans ce nouvel écosystème ?

- Comment piloter l'analyse des masses de données dans ce nouvel écosystème en prenant en compte l'existant en termes d'applications métiers ?

Mise en place de la stratégie de recherche et développement

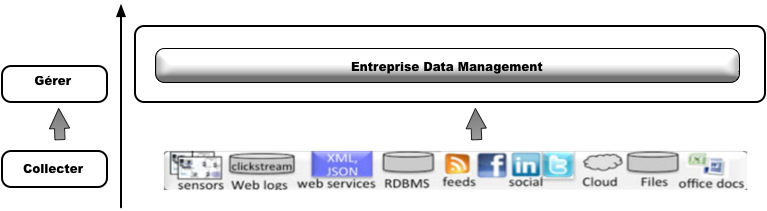

- architecture de la gestion des données dans l'écosystème ;

- architecture du système analytique dans l'écosystème.